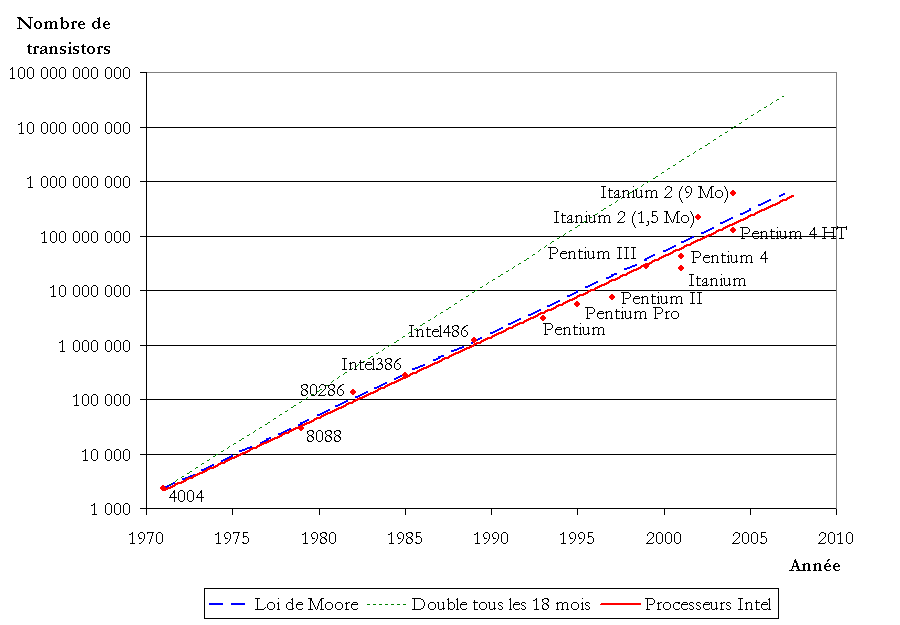

En 1965, Gordon Moore, alors ingénieur chez IBM, constata que la puissance des processeurs depuis 1959 doublait tous les 18 mois environ. Ce constat a dès lors été érigé comme Loi (totalement empirique) d’évolution des composants électronique.

Les conséquences de cette loi sont nombreuses :

- les machines à concevoir les processeurs doivent être changées tous les 2 ans, à raison de plus d’1 milliards de dollars par chaîne de production, incitant un renouvellement rapide du marché des appareils électroniques, et laissant de côté les notions comme le recyclage, la multiplication des supports des données personnelles, etc.

- les systèmes d’exploitation (Windows, Mac OS X) s’allourdissent plus vite que les machines ne deviennent rapides, donc le gain de performance pour des usages quotidiens n’est pas perceptible

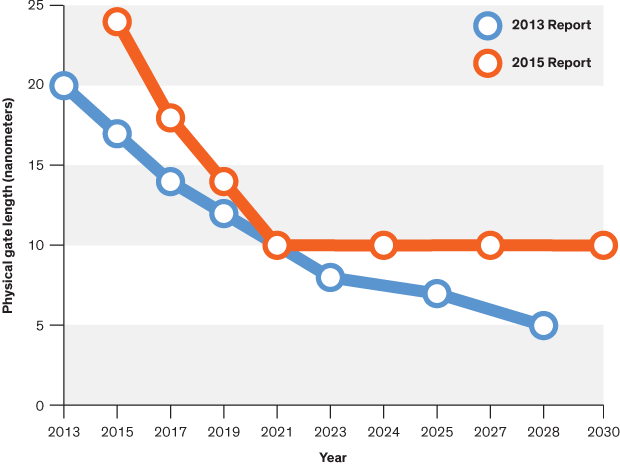

- les limites physiques du silicium le contraignent à une finesse de gravure de 32 nm (nanomètres), or cette limite a été franchie en 2011, notamment par les processeurs Intel Sandy Bridge, ce qui implique des incohérences quantiques, donc des calculs à faire 5 fois pour valider leurs résultats (d’où une usure prématurée des composants et une grande baisse de fiabilité des composants). Et il n’existe aucun concurrent capable de remplacer de manière aussi pronocée le silicium à très court terme.

- la capacité à multiplier les coeurs au sein d’un processeur dispose aussi de ses limites (on arrive aujourd’hui à une moyenne de 4 coeurs, mais cela n’est pas suffisant pour compenser la Loi de Moore)

En février 2016, l’organisme de définition des directives dans la conception des semoconducteurs (ITRS) a établi la fin de la Loi en 2021, stabilisant la gravure des composants à 10 nm.

Les conséquences de la fin de la Loi de Moore sont nombreuses aussi :

- repenser la conception des composants électroniques, misant davantage sur des structures tri-dimensionnelles

- repenser le marché de l’électronique (cycle de renouvellement et durée du SAV), et limiter l’obsolescence programmée

- repenser la notion de performance, et j’adore ce test entre un Mac de 1984 et un PC de 2007, rien qu’au démarrage…

- repenser la notion de généralisme, en orientant la recherche vers des composants spécifiques, donc optimisés (comme les processeurs graphiques), voire à travailler avec la multiplicité de processeurs spécifiques (comme ce fut le cas à une époque avec les coprocesseurs arithmétiques)

Personnellement, je pense que les vrais changements, surtout au niveau utilisateur, n’apparaîtront pas avant une dizaine d’années. D’ici là, on continuera à devoir changer matériels et logiciels pour cause de « fin de prise en charge » par les mises à jour ou les SAV.